Semmelbrosel

Dabbler

- Joined

- Jul 5, 2013

- Messages

- 12

Hallo Miteinander,

mir ist wie anderen auch schon das Malör passiert, das Platten sich nun im Stripeverbund zum bestehenden Pool verbunden haben. Viele schreiben das man den alten Pool löschen soll und neu ausbauen.

Da im Pool 20TB an Daten sind ist das mal nicht so einfach

Das Problem ist, wenn nun eine der Platten da0 oder da 6 defekt gehen, ist alles weg.

Beim suchen im Internet habe ich das schon gefunden.

http://blog.delphix.com/alex/2015/01/15/openzfs-device-removal/

Aber anscheinend geht das in Freenas nicht.

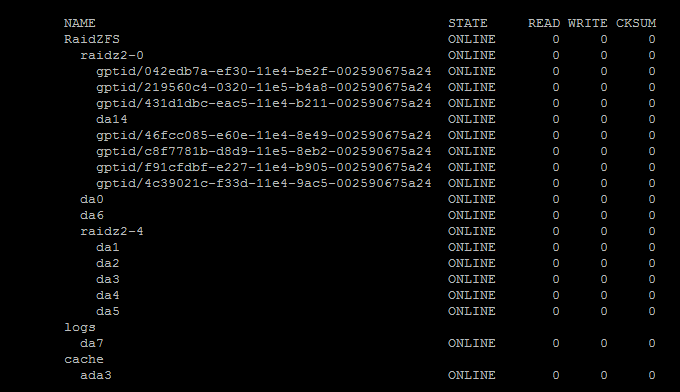

Hier der Pool

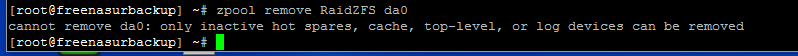

Hier wenn ich versuche nun die Platte aus dem Pool zu lösen.

Ich habe schon 3x8TB Festplatte eingebaut, lasse gerade die Daten per Snapshot dorthin kopieren, was aber Wochen dauern wird. Leider sehen ich hier auch nicht wie weit der Transfer ist.

Ich in etwas ratlos was ich machen soll.

Hat jemand ein Idee?

Es dürfen sich gerne Profis oder gewerbliche melden die sich mit der Materie sehr gut auskennen.

Zeit wird auch vergütet.

Gruß Mario

mir ist wie anderen auch schon das Malör passiert, das Platten sich nun im Stripeverbund zum bestehenden Pool verbunden haben. Viele schreiben das man den alten Pool löschen soll und neu ausbauen.

Da im Pool 20TB an Daten sind ist das mal nicht so einfach

Das Problem ist, wenn nun eine der Platten da0 oder da 6 defekt gehen, ist alles weg.

Beim suchen im Internet habe ich das schon gefunden.

http://blog.delphix.com/alex/2015/01/15/openzfs-device-removal/

Aber anscheinend geht das in Freenas nicht.

Hier der Pool

Hier wenn ich versuche nun die Platte aus dem Pool zu lösen.

Ich habe schon 3x8TB Festplatte eingebaut, lasse gerade die Daten per Snapshot dorthin kopieren, was aber Wochen dauern wird. Leider sehen ich hier auch nicht wie weit der Transfer ist.

Ich in etwas ratlos was ich machen soll.

Hat jemand ein Idee?

Es dürfen sich gerne Profis oder gewerbliche melden die sich mit der Materie sehr gut auskennen.

Zeit wird auch vergütet.

Gruß Mario