IndieCoopz

Explorer

- Joined

- Nov 4, 2022

- Messages

- 50

Hallo zusammen, mir ist etwas aufgefallen und ich bin nicht sicher ob das noch ein SCALE Bug ist oder ob ich ein Verständnisproblem habe.

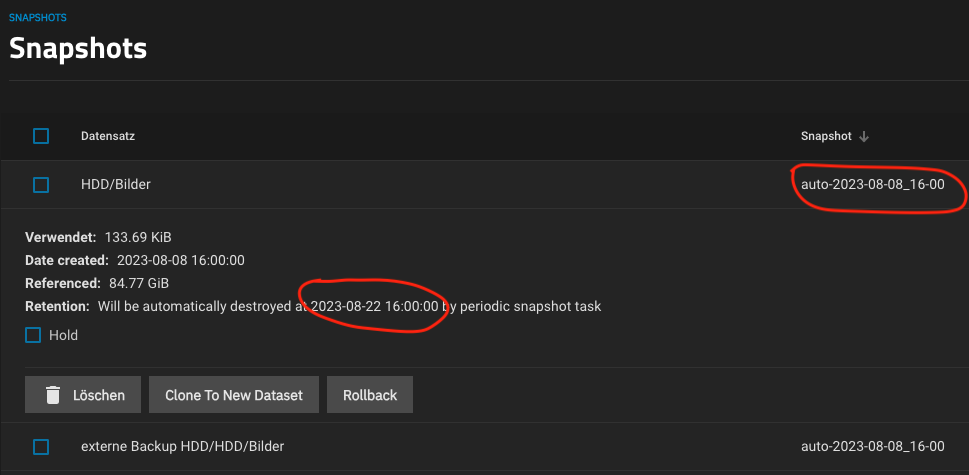

Ich erstelle aller 8h einen Snapshot per Periodic Snapshot Task. Aufbewahrungsdauer 2 Wochen.

Das scheint auch zu passen wenn ich den Snapshot überprüfe:

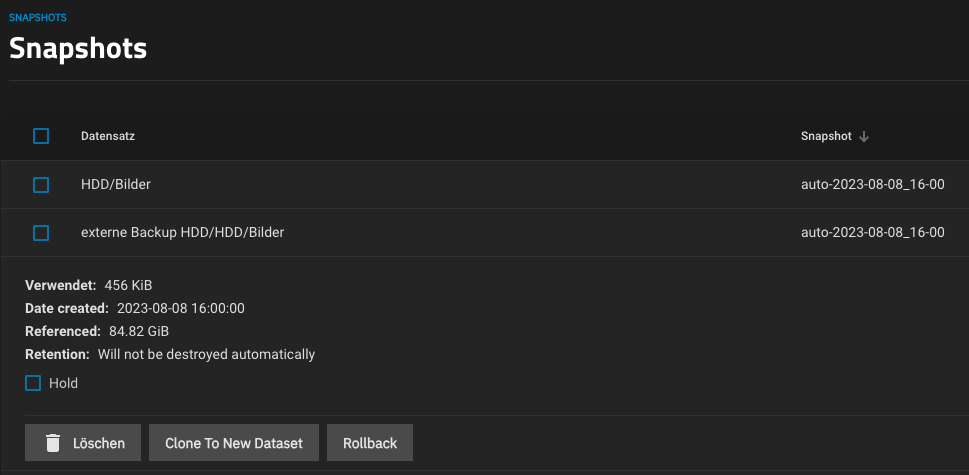

Wenn ich nun den Replizierten Snapshot auf meinem Backup ansehe, steht dort das dieser nie abläuft:

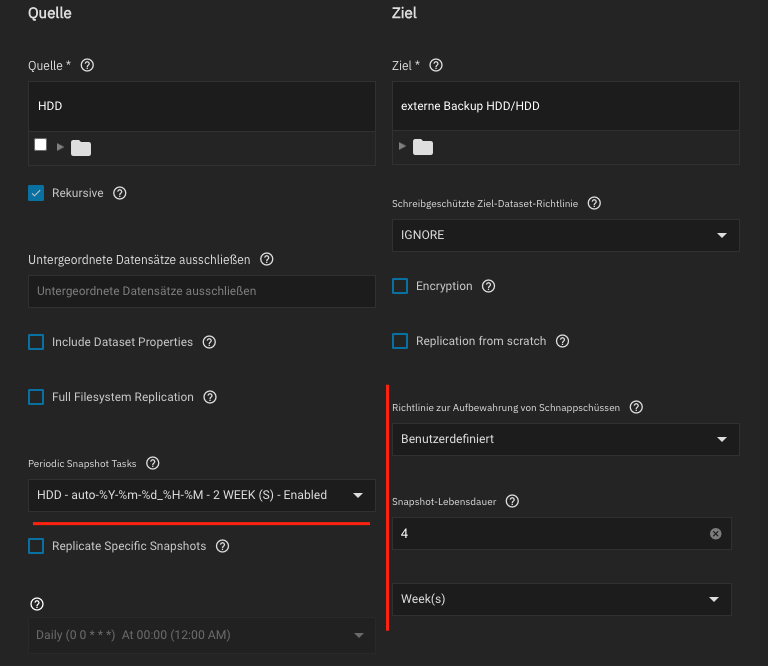

Mein Replikationsjob ist aber so eingestellt, dass dieser den Snapshot auf 4 Wochen haltedauer Backuppen soll:

Habe ich hier etwas falsch konfiguriert, einen Denkfehler oder ist es ein (Anzeige) Bug? :)

Ich erstelle aller 8h einen Snapshot per Periodic Snapshot Task. Aufbewahrungsdauer 2 Wochen.

Das scheint auch zu passen wenn ich den Snapshot überprüfe:

Wenn ich nun den Replizierten Snapshot auf meinem Backup ansehe, steht dort das dieser nie abläuft:

Mein Replikationsjob ist aber so eingestellt, dass dieser den Snapshot auf 4 Wochen haltedauer Backuppen soll:

Habe ich hier etwas falsch konfiguriert, einen Denkfehler oder ist es ein (Anzeige) Bug? :)