Здравствуйте,

случилось то, что случается у всех, кто не делает резервные копии: я удалил датасет (из GUI)

zpool history:

2018-11-17.15:36:01 zfs destroy -r WD2TB_Mirror/dataset_Office

естественно все снапшоты внутри датасета тоже удалились, после этого никаких изменений не производилось.

-как можно восстановить удаленные данные? и не потерять имеющиеся датасеты!

пул WD2TB_Mirror это RAID1 - два диска WD 2TiB серия YELLOW, есть еще два "таких же" серии GOLD

можно ли (и нужно ли) реплицировать имеющийся пул на эту пару- либо для опытов, либо для сохранности имеющихся данных

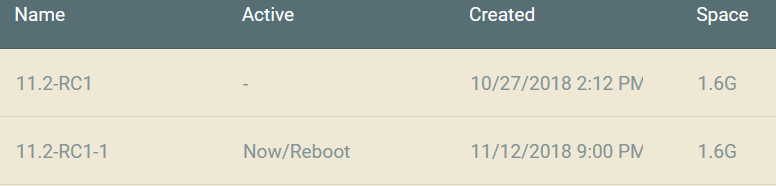

в system/boot environment/ - есть "состояние" системы, в котором этот датасет, еще присутствует

Спасибо.

случилось то, что случается у всех, кто не делает резервные копии: я удалил датасет (из GUI)

zpool history:

2018-11-17.15:36:01 zfs destroy -r WD2TB_Mirror/dataset_Office

естественно все снапшоты внутри датасета тоже удалились, после этого никаких изменений не производилось.

-как можно восстановить удаленные данные? и не потерять имеющиеся датасеты!

пул WD2TB_Mirror это RAID1 - два диска WD 2TiB серия YELLOW, есть еще два "таких же" серии GOLD

можно ли (и нужно ли) реплицировать имеющийся пул на эту пару- либо для опытов, либо для сохранности имеющихся данных

в system/boot environment/ - есть "состояние" системы, в котором этот датасет, еще присутствует

Спасибо.