Добрый день форумчане!

Имею FreeNAS-11.1-U5

Zvol - 10.2T

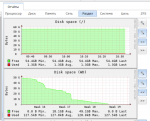

На пуле закончилось место, полностью. График:

zvol отдан по iscsi ESXi хосту.

Все ВМ которые хранятся на нем, не работают, т.к. нет места для хранения *.vmdk (типа)

Первое на что подумал, не правильно представлен стораж хосту, т.к. из vmware было видно что есть еще 700+ Gb

проблему пробовал решить следующим образом:

1) Подоткнул диск бОльшего объема в сервер (где то вычитал что расширить zvol можно только заменой дисков, на более объемные), поставил на замену, увидел статус ресильвера в пару дней, пошел искать другой способ.

2)- Загрузился под LiveCD( не дожидаясь конца ресильвера), установил туда ZFS, сделал import своего zvol

- установил vmfs-tools, при помощи vmfs-fuse примаунтил zvol, скопировал 2 vmdk по 300 Gb к себе на машину.

- Загрузился под своим FreeNAS, на пуле появилось 12+Мб свободного места, стораж примонтировался в ESXi! Удалил скопированные vmdk.

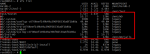

- ESXi показывает что свободного места стало 1.15 Тб+ (zfs list показывал 12 M!)

- Начал мигрировать диски на другие сторожилки, и вот, снова свободного места 0 байт. Снова все отваливается.

Из гугления понятно что не удаляются блоки данных с zero files(или как то так)

Не знаю что делать, нид хелп!

Сейчас запущен zpool scrub, но выполняться он будет, судя по всему, 2-3 дня. Куда копать уже не знаю.

Может кто сталкивался?

Как можно попробовать высвободить не использующееся место в пуле? Снапшотов нет!

Имею FreeNAS-11.1-U5

Zvol - 10.2T

На пуле закончилось место, полностью. График:

zvol отдан по iscsi ESXi хосту.

Все ВМ которые хранятся на нем, не работают, т.к. нет места для хранения *.vmdk (типа)

Первое на что подумал, не правильно представлен стораж хосту, т.к. из vmware было видно что есть еще 700+ Gb

проблему пробовал решить следующим образом:

1) Подоткнул диск бОльшего объема в сервер (где то вычитал что расширить zvol можно только заменой дисков, на более объемные), поставил на замену, увидел статус ресильвера в пару дней, пошел искать другой способ.

2)- Загрузился под LiveCD( не дожидаясь конца ресильвера), установил туда ZFS, сделал import своего zvol

- установил vmfs-tools, при помощи vmfs-fuse примаунтил zvol, скопировал 2 vmdk по 300 Gb к себе на машину.

- Загрузился под своим FreeNAS, на пуле появилось 12+Мб свободного места, стораж примонтировался в ESXi! Удалил скопированные vmdk.

- ESXi показывает что свободного места стало 1.15 Тб+ (zfs list показывал 12 M!)

- Начал мигрировать диски на другие сторожилки, и вот, снова свободного места 0 байт. Снова все отваливается.

Из гугления понятно что не удаляются блоки данных с zero files(или как то так)

Не знаю что делать, нид хелп!

Сейчас запущен zpool scrub, но выполняться он будет, судя по всему, 2-3 дня. Куда копать уже не знаю.

Может кто сталкивался?

Как можно попробовать высвободить не использующееся место в пуле? Снапшотов нет!